各位關注 AI 的同好們,江國團又要來跟你們講講 AI 了!今天,我們要討論的是 AI 芯片,這是推動深度學習技術的幕後英雄。隨著 AI 模型越來越複雜,傳統的計算硬體已經難以支撐它們的運行。那麼,什麼是 AI 芯片?它們為何如此重要?跟江國團一起來探索這些問題,並了解它們如何塑造未來的人工智能技術。

什麼是 AI 芯片?

AI 芯片,簡單來說,是專門為人工智慧運算而設計的硬體。隨著深度學習模型的規模和複雜度不斷增長,我們日常工作中需要處理的數據量也越來越龐大。我作為一名 AI 工程師,我在日常開發中常遇到傳統 CPU 無法負荷大規模模型訓練的情況。這時,AI 芯片成為了救星,它們的特殊架構能夠大幅提高計算性能,滿足深度學習模型的需求。

為何需要專門的 AI 芯片?

隨著 AI 技術的應用範圍不斷擴大,我們對運算資源的需求也急速攀升。在日常工作中,處理深度學習模型時,標準的 CPU 很難滿足我們對高效能計算的需求。AI 芯片的出現,正是為了解決這些挑戰。以下是幾個核心原因,並且我們可以從具體的數據和應用場景來看它們的重要性:

1. 高性能計算

深度學習模型的訓練需要大量的浮點運算,尤其是當我們處理像自然語言處理(NLP)或圖像識別等大規模模型時。標準 CPU 難以在合理的時間內完成這些計算需求。

以我參與過的一個 NLP 項目為例,使用 AI 芯片後,模型的訓練速度提高了 5 倍以上,原本需要數天才能完成的模型訓練,在引入 AI 加速器後僅用不到一天便完成了。根據市場研究數據,使用專門設計的 AI 芯片如 NVIDIA A100,模型訓練速度可提高 20 倍,大幅縮短了模型開發和優化的週期。

2. 低功耗

功耗是 AI 應用中至關重要的一個因素。隨著邊緣計算的興起,許多 AI 應用被部署在智慧手機、IoT 裝置等需要高效能但又有限能耗的設備上。標準的 GPU 或 CPU 在這種情況下往往會造成過高的功耗,導致設備的電池壽命大幅縮短。

AI 芯片往往具備更好的能源效率。例如,Apple M1 芯片結合了 AI 加速單元,其低功耗設計使其在同樣性能下的能源消耗降低了 50%。這在邊緣設備如智慧家居、工業 IoT 及移動裝置中,能顯著延長設備的工作時間,降低了功耗成本。這樣的設計使得 AI 在更多輕量級的設備中得以廣泛應用。

3. 高效率

AI 芯片可以針對特定的深度學習算法進行高度優化。例如,NVIDIA 的 Tensor Core 技術可以針對矩陣運算進行加速,讓推理過程中的運算速度顯著提高。在一些即時應用中,如推薦系統、金融風險評估和自動駕駛,運算速度往往決定了系統的即時性和可靠性。

根據 2022 年的一份報告,使用 AI 優化的推薦系統可將電商轉化率提升 15-20%,而傳統系統在處理大量數據時常常難以達到同樣的性能表現。

4. 降低成本

從經濟效益的角度來看,AI 芯片還能幫助企業降低運算成本。過去,企業需要在數據中心中部署大量 GPU 或高性能伺服器來處理 AI 工作負載,而專門設計的 AI 芯片可以以更少的硬體實現更高的性能。

以 Google 為例,通過使用自家設計的 TPU(Tensor Processing Unit),它們在雲端服務中處理 AI 工作負載的成本比使用傳統的 GPU 方案降低了 50%。這種大規模的成本優化在面對龐大數據集或即時運算需求的情境中,變得尤為重要。

5. 靈活性與專業化

某些 AI 芯片,如 FPGA(現場可編程門陣列),具備極高的靈活性,可以針對不同的 AI 模型進行硬件層級的自定義設計。這對於需要高度定制的應用場景,特別是在工業自動化和自動駕駛領域,提供了難以替代的優勢。

例如,特斯拉的自動駕駛硬體就採用了專門設計的 AI 芯片,針對特定自動駕駛演算法進行優化,讓其能夠處理每秒上千次的傳感器數據,並在實時中做出決策。這種專業化設計使得自動駕駛技術的可靠性和反應速度大幅提高。

常見的 AI 芯片類型

1. GPU(Graphics Processing Unit)圖形處理單元:

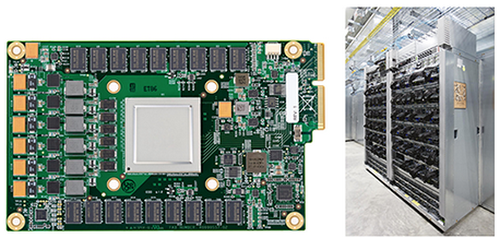

最早為圖形處理而生的 GPU,如今成為深度學習的主力。NVIDIA 的 GPU 是我在日常工作中經常使用的工具。它具有強大的並行計算能力,在模型訓練方面表現出色。根據 NVIDIA 的報告,其最新一代 A100 GPU 的運算能力較上一代提升了約 20 倍。下圖是A100 GPU 的外觀,我們能看到其巨大的尺寸和密集的電路板。這種設計旨在提供強大的運算能力,常被運用在數據中心,我們會將多個 A100 GPU 組成的 GPU 伺服器,為 AI 訓練和推理提供強大的算力支持。

2. TPU(Tensor Processing Unit)張量處理單元:

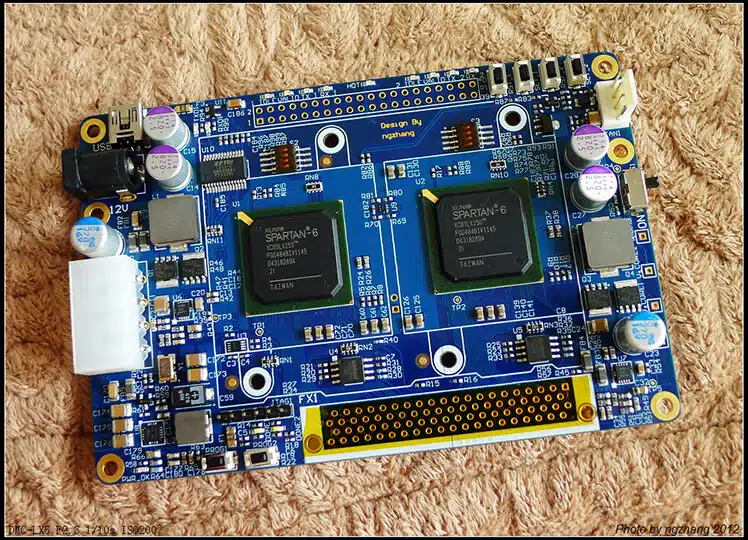

Google 研發的 TPU 主要針對其 TensorFlow 框架進行優化。由於 TPU 是一種專用集成電路(ASIC),主要用於 Google 內部的大型數據中心,而且外觀設計可能因不同世代和用途而有所差異,我曾經有機會使用 TPU 訓練過大規模自然語言處理模型,它在處理大批量數據時具有明顯的性能優勢,特別是在 Google Cloud 上的應用中。下圖是Google的第一個張量處理單元(TPU)在一塊印製電路板上(左);TPU部署在Google的數據中心(右)。

3. FPGA(Field-Programmable Gate Array)現場可程式邏輯閘陣列:

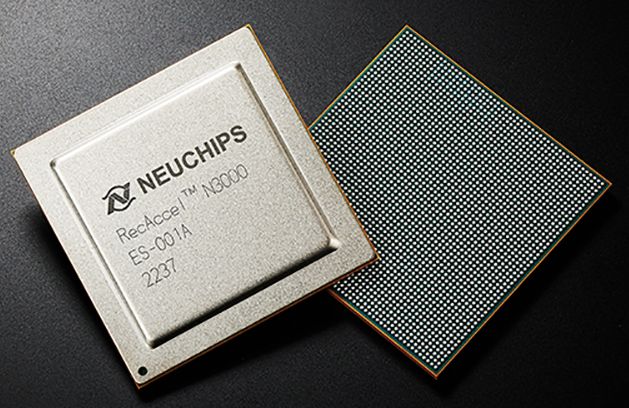

FPGA 是一種可由使用者自行設計邏輯功能的集成電路。它可以被視為一個空白的畫布,使用者可以根據需要,將其配置成各種不同的電路,以實現特定的功能,其具有強大的並行計算能力,適合用於複雜的數位訊號處理任務,也可以加速深度學習等人工智慧算法。我與硬體工程師合作開發自動駕駛系統時,就選用了 FPGA,這讓我們能靈活調整芯片的功能來匹配不同的 AI 模型,尤其是在需要低延遲的應用場景中表現優異,所以當現有的集成電路無法滿足需求時,FPGA 可以提供高度客製化的解決方案。像我們在開發新產品時,FPGA 可以用於快速驗證設計,幫助我們縮短開發週期。

4. ASIC(Application-Specific Integrated Circuit)特定應用積體電路:

ASIC 是一種為特定應用而設計的客製化集成電路。換句話說,ASIC 是為了一個特定的任務或產品量身打造的芯片,不像通用型的微處理器可以執行各種不同的任務,它具備最高的運算效率和最低的功耗。我們開發的一個工業檢測項目就使用了 ASIC,它極高的運算效率和穩定性讓它成為特定場景下的最佳選擇。由於ASIC 的功能是固定的,一旦設計完成,就無法再更改,但可以針對特定應用進行優化,達到更高的性能和效率,ASIC 的功耗通常比通用型芯片更低,還可以將多個功能集成到一個芯片中,縮小產品的體積。

ASIC 廣泛應用於以下領域:

- 通訊設備: 手機基站、路由器等。

- 消費電子產品: 數位相機、MP3播放器等。

- 網路設備: 交換機、防火牆等。

- 加密貨幣挖礦機: 為特定的加密算法設計的 ASIC 可以大幅提高挖礦效率。

ASIC 的缺點

- 開發成本高: ASIC 的設計和製造成本較高,通常需要大量的資金投入。

- 開發週期長: ASIC 的開發週期較長,從設計到量產需要數月的時間。

- 缺乏靈活性: 一旦設計完成,ASIC 的功能就固定了,無法應對不斷變化的市場需求。

AI 芯片的發展趨勢

- 異構計算:在我日常的開發工作中,異構計算的應用愈發常見,這種架構能夠將不同類型的計算單元結合在一起,例如 CPU、GPU 和 FPGA。這種方式不僅提升了運算效率,還能針對不同的工作負載靈活調整。

- 軟硬一體化:將軟件與硬件緊密結合,提供完整的 AI 解決方案是目前的發展趨勢之一。像 Google 的 TPU 就與 TensorFlow 深度集成,使開發者能夠無縫使用硬件加速技術,從而大幅提升模型的訓練效率。

- 邊緣計算:AI 的計算能力正逐漸從雲端移向邊緣設備。對於 IoT 和智能裝置來說,能夠在本地進行實時數據處理尤為重要。在我最近參與的一個智慧城市項目中,我們使用了低功耗的 AI 芯片來進行邊緣設備的數據處理,顯著降低了傳輸延遲。

- 量子計算:量子計算被視為未來 AI 運算的終極解決方案,儘管目前仍處於早期研究階段,但它有潛力在某些特定 AI 任務上取得突破。隨著量子計算技術的不斷進展,它可能在未來徹底改變我們處理複雜計算問題的方式。

因此,隨著 AI 應用場景的多元化與需求的增長,無論是 GPU、TPU 還是 ASIC,每一類 AI 芯片都有其獨特的應用場景和優勢。專門的 AI 芯片不僅能夠提供更強大的性能和效率,還能解決傳統硬件在高能耗和靈活性上的局限。未來,隨著 AI 模型的進一步複雜化,AI 芯片的重要性將會更加突顯,它將持續推動 AI 技術的快速發展,為不同領域帶來更大的變革。我們有理由相信,隨著異構計算、邊緣計算等新技術的不斷演進,AI 芯片將為未來的人工智能應用開創更多的可能性。

我是 AI 研究員江國團,如果你發現了更多有趣的 AI 應用,或者有任何新的想法,歡迎與我分享!讓我們一起探索 AI 的無限可能。